知识库部署记录

应用场景

知识库技术的出现旨在为大语言模型构建一套可验证、可追溯和可更新的知识体系,以解决大模型数据时效性和领域专长不足的问题。通过搭载外部知识库,大模型在回答问题时可以结合自身训练数据和外部知识库,弥补信息缺失。然而,由于技术限制(如上下文长度、检索精度等),大模型无法完全消化整个知识库,而是通过搜索和匹配相关度最高的内容来回答问题。

以总结十篇文章为例,直接要求大模型分类和总结会因文章内容量过大触发上下文限制而失败。通过分解任务,先让大模型总结一家公司的信息,再通过编程工具(如insert)实现重复操作,最终由Cherry studio进行总结,成功完成任务。目前AI的智能度还不够高,会有种种的限制,只有通过思维分解和工具选择,优化思考过程,才能充分发挥AI的潜力。

准备工作

- 已安装WSL

- 已安装Docker:教程链接

安装RAGflow

从github上拉取该项目,推荐使用命令行

方式一:命令行方式

在M:\RAGFlow这个路径下打开终端

1 | git clone https://github.com/infiniflow/ragflow.git |

方式二:手动下载

项目链接:https://github.com/infiniflow/ragflow

修改文件

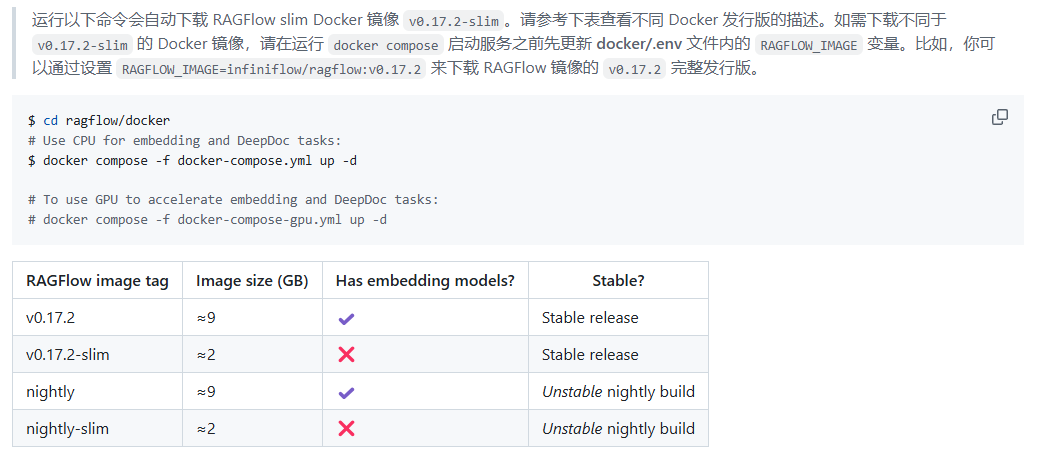

需要注意的是,下载的项目并不是完整版,所以我们还需要改一下文件,以下是官网原文:

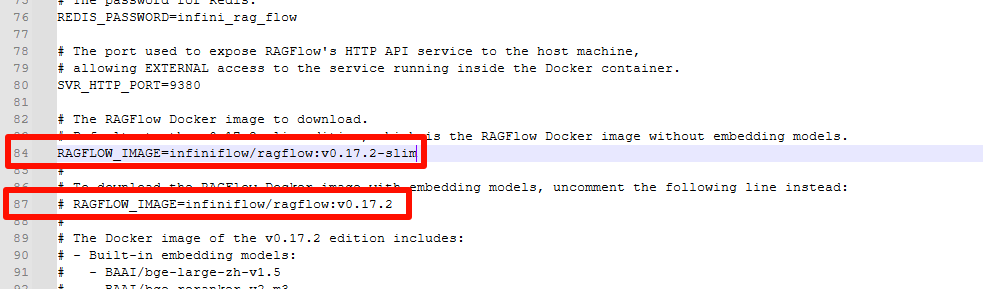

所以我们需要先修改M:\RAGFlow\ragflow\docker\.env这个文件,将84行注释掉,将87行取消注释

改后应该是:

1 | # RAGFLOW_IMAGE=infiniflow/ragflow:v0.17.2-slim |

拉取docker镜像

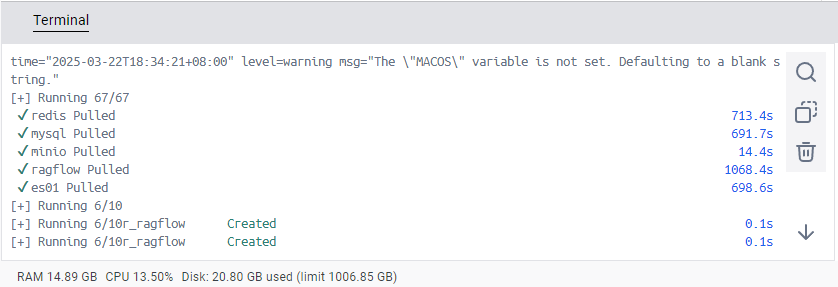

然后进入M:\RAGFlow\ragflow\docker文件夹内安装Docker

1 | docker compose -f docker-compose.yml up -d |

大概用了20分钟下完了

测试是否能够运行

在浏览器打开

1 | localhost:80 |

显示这个界面

然后注册一个账号就可以了

问题记录

我这里运行这行安装docker的命令时

1 | docker compose -f docker-compose.yml up -d |

显示docker hub的用户名和密码不正确,可以在终端中使用docker login重新登录一下

在docker上安装ollama

官方文档链接:https://ragflow.io/docs/dev/deploy_local_llm

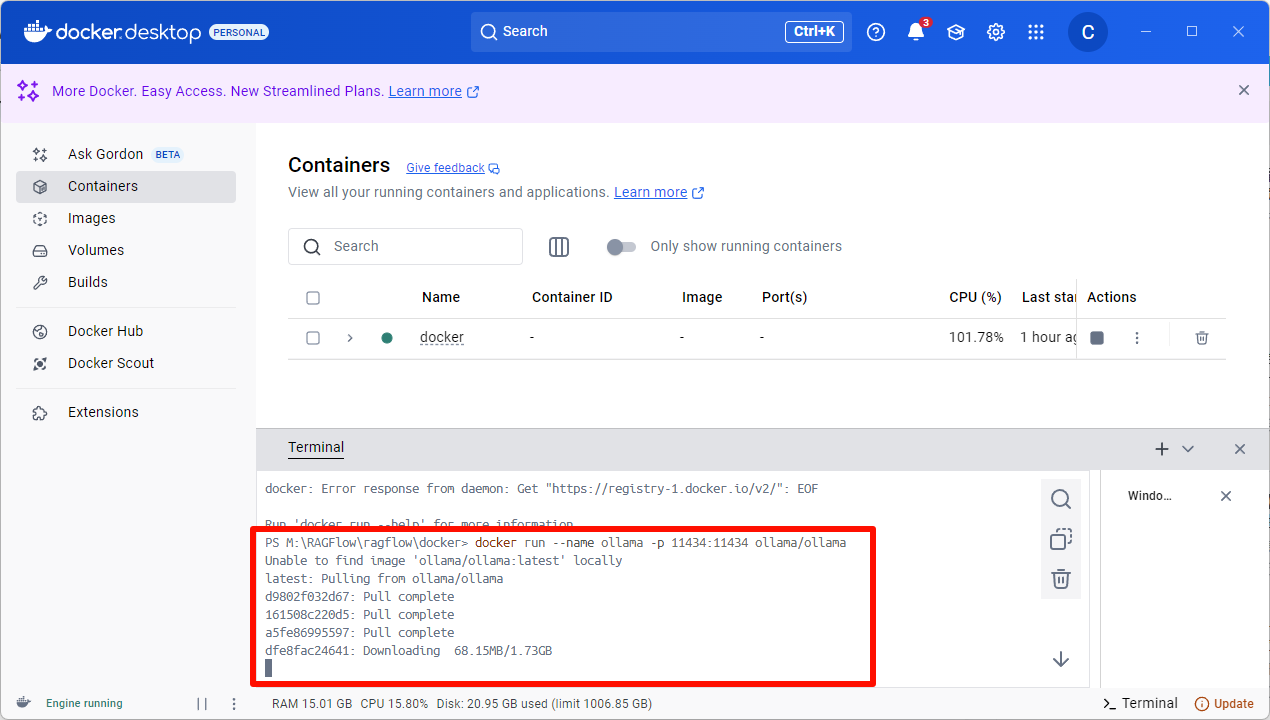

输入以下命令安装ollama:

1 | docker run --name ollama -p 11434:11434 ollama/ollama |

等待安装完毕

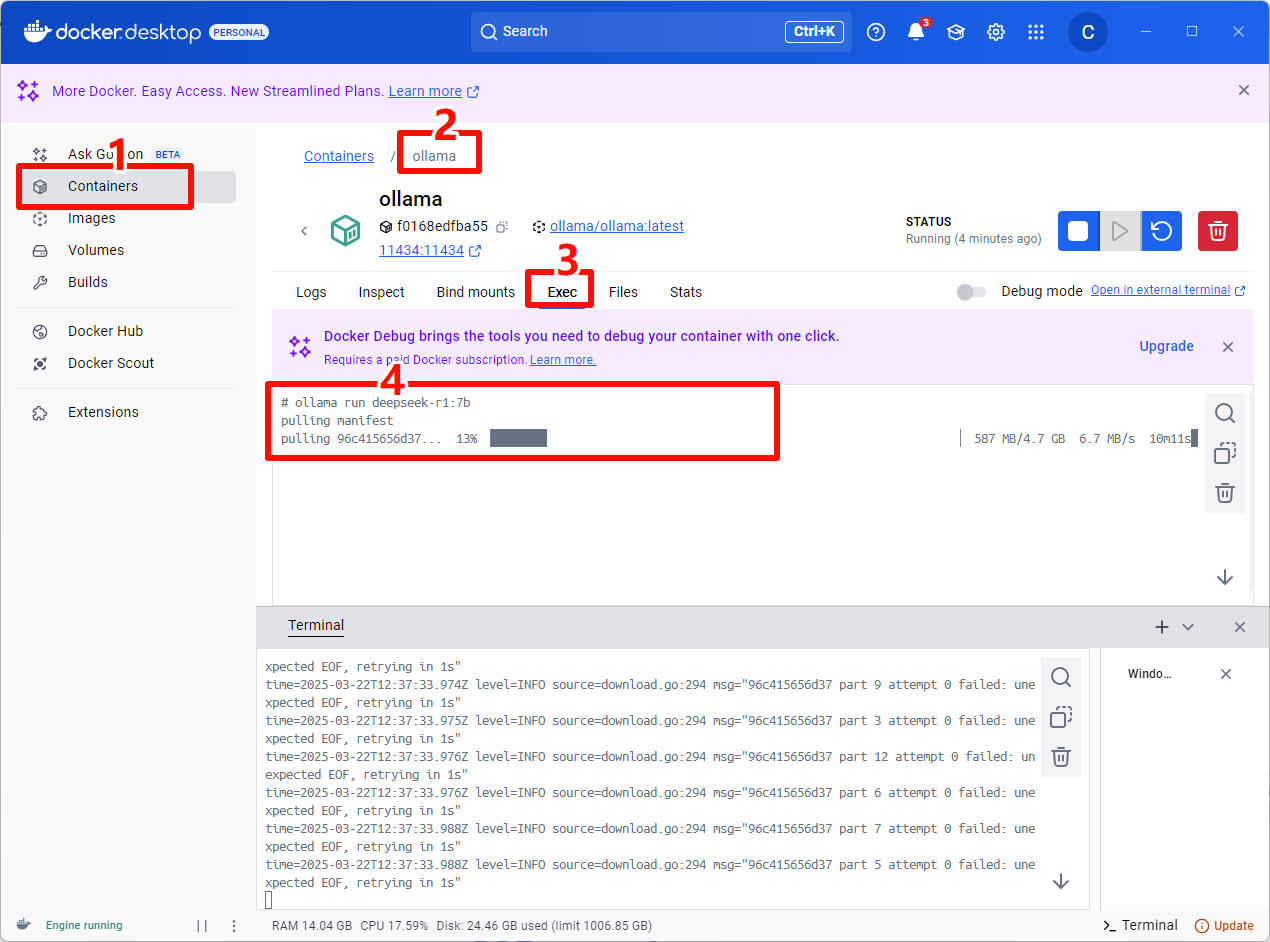

然后在ollama的Exec中输入安装大模型命令

这里安装deepseek-r1的7b参数量模型

1 | ollama run deepseek-r1:7b |

配置RAGFlow

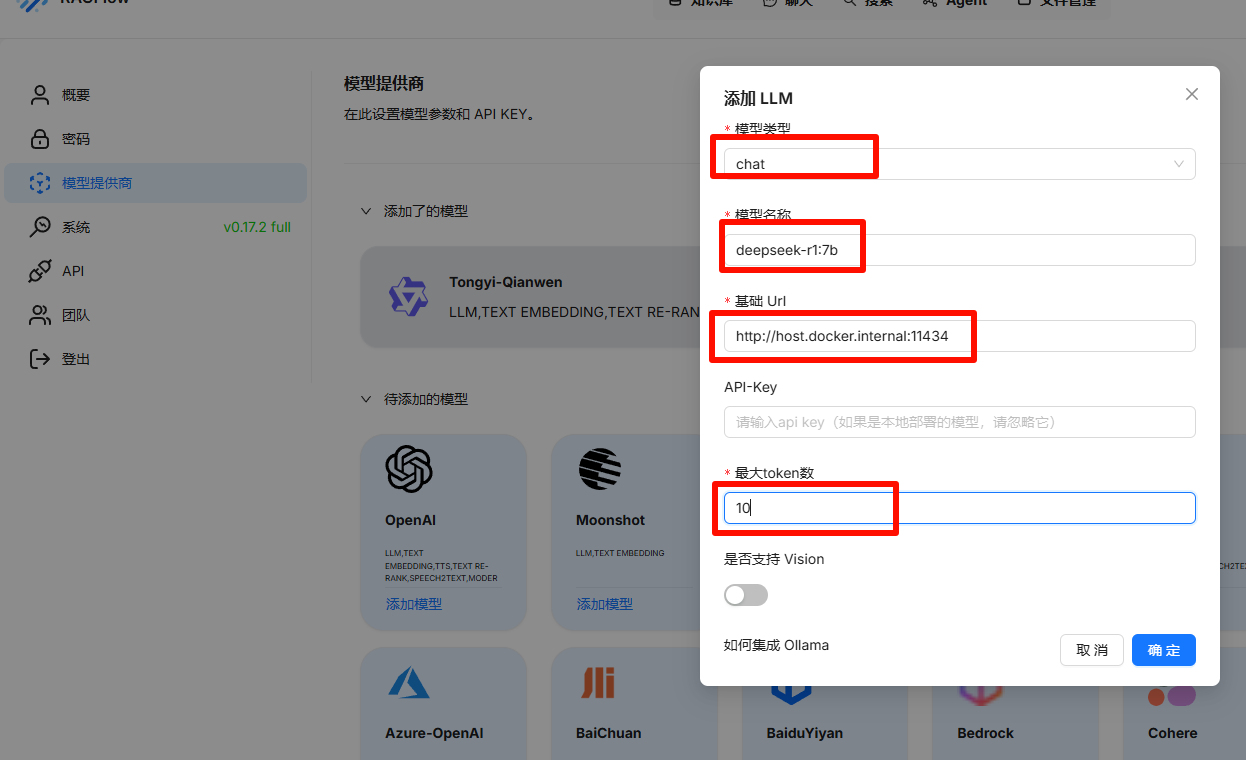

等待下载完毕后,回到RAGFlow的网页,在网页中关联ollama

在模型提供商里点ollama,然后在ollama中添加deepseek-r1模型

模型类型:选chat

模型名称:直接填下载模型时的名称就可以deepseek-r1:7b

基础Url:这个需要注意端口要对上

API-Key:大模型是本地部署的,这里不需要填

最大token数:按自己显卡算力来就可以

其他默认

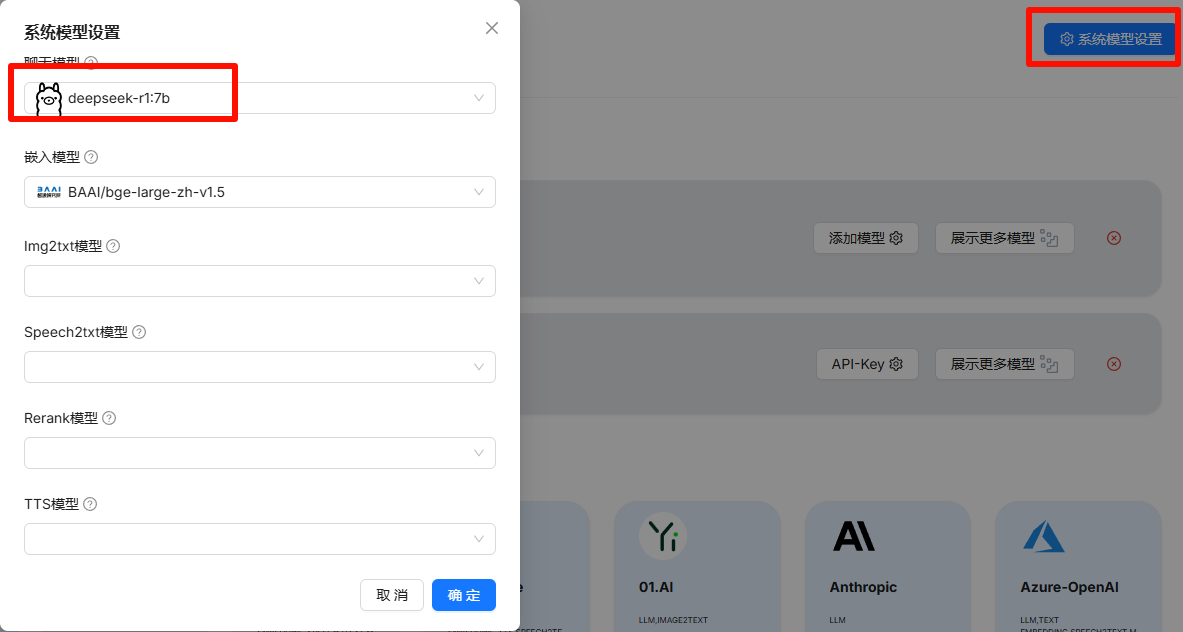

在系统模型设置里将聊天模型设置为刚配置的deepseek,其他默认即可

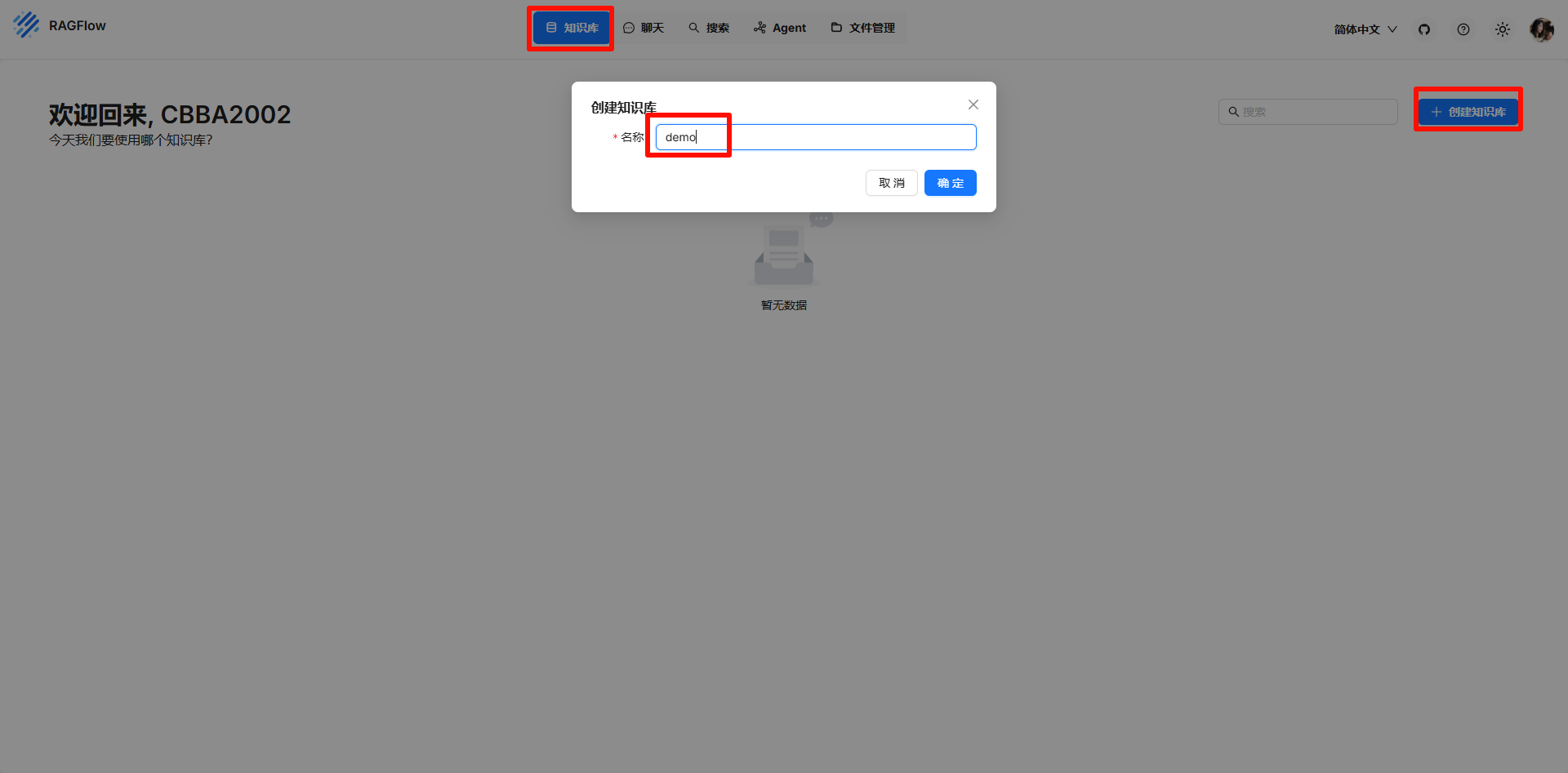

然后创建一个知识库

在知识库中上传文件

然后在聊天中新建助理,只需要注意知识库、Rerank模型需要选一下,其他默认即可

现在就可以正常使用了